随着人工智能技术的飞速发展,对于数据处理能力的处理和存储容量的需求也在不断增加。传统的内存和显存技术在面临AI计算时,往往会遇到宽带和容量上的瓶颈,这就是所谓的“内存墙“问题。然而,随着高带宽内存(HBM)技术的出现,这一问题得到了有效的解决,HBM内存与AI处理器的结合,正在加速人工智能的未来。

一、HBM内存技术的特点

HBM内存技术采用了3D堆叠技术,将多个DRAM芯片堆叠在一起,通过垂直互连通道(TSVs)连接,从而实现了高密度、高带宽和低延迟的内存解决方案。与传统的GDDR5和GDDR6显存相比,HBM内存具有以下几个显著的特点:

高带宽:HBM内存的带宽可以达到传统显存的数倍,这使得它能够更快地传输数据,满足AI处理器对高带宽的需求。

高容量:HBM内存采用了多层堆叠技术,可以在小尺寸的封装中实现大容量的存储,从而满足AI计算中大型数据集的需求。

低功耗:HBM内存采用了先进的制造工艺和散热技术,能够在保证高性能的同时降低功耗,提高系统的稳定性和可靠性。

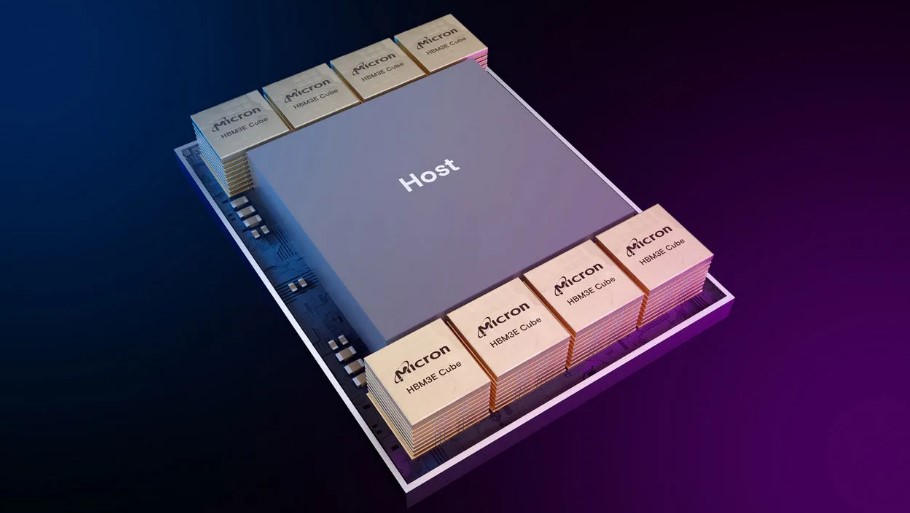

图:HBM与AI处理器的融合 加速人工智能的未来

二、HBM内存与AI处理器的完美结合

AI处理器是人工智能技术的核心部件,它负责执行复杂的计算任务,包括深度学习、神经网络训练等。然而,AI处理器的性能往往受到内存带宽和容量的限制。HBM内存的出现,为AI处理器提供了理想的内存解决方案。

解决内存墙问题:HBM内存的高带宽和低延迟特性,使得它能够有效地解决AI处理器面临的内存墙问题。它能够将数据更快地传输到AI处理器中,从而提高计算效率和速度。

加速AI训练:在AI训练过程中,需要处理大量的数据集和模型参数。HBM内存的大容量和高带宽特性,能够支持更大的数据集和更复杂的模型训练,从而加速AI训练的过程。

提高系统性能:HBM内存与AI处理器的结合,能够构建出高性能的AI计算系统。这些系统不仅能够处理复杂的AI任务,还能够在保持高性能的同时降低功耗和成本。

随着人工智能技术的不断发展,对于高性能计算和数据存储的需求将会继续增加。HBM内存作为一种先进的内存技术,将会在AI领域发挥越来越重要的作用。未来,我们可以期待更多的AI处理器采用HBM内存技术,从而推动人工智能技术的进一步发展和应用。

同时,随着HBM技术的不断进步和成熟,它的成本也将会逐渐降低,使得更多的企业和研究机构能够使用到这种先进的内存技术。这将有助于推动人工智能技术的普及和应用,为社会带来更多的便利和价值。