大模型的发展对AI基础设施提出了全方位的新要求,从算力、数据服务到平台服务模式,再到硬件和软件的更新,以及绿色节能化发展,都需要AI基础设施进行相应的升级和优化,以支撑AI技术的进一步发展和应用。根据云岫资本,AI硬件基础设施、先进封装、高端制造国产替代成为半导体投资热点。

AI大模型高速发展 算力需求不断提高

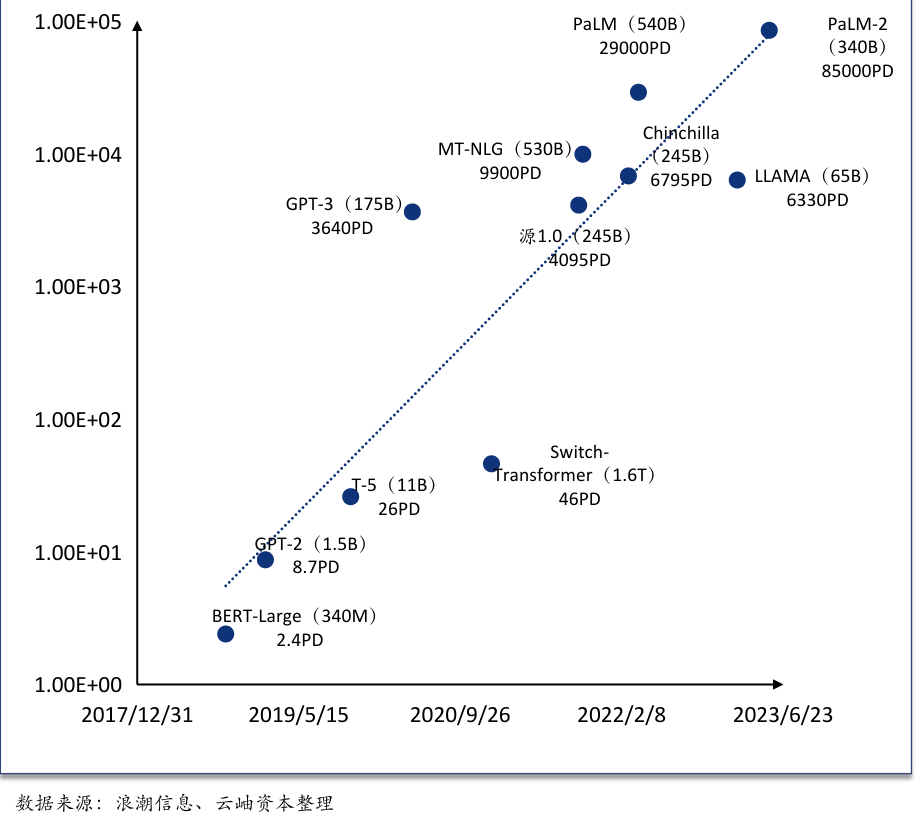

AI大模型的发展需要更高的算力支持。与传统的机器学习模型相比,AI大模型通常包含更多的参数和更复杂的网络结构,因此需要更强大的计算能力来进行训练和推理。根据云岫资本,为了实现多模态支持、拓展上下文长度、提升速率限制等性能的提升,大模型预训练使用的参数量和数据量呈爆炸性增长。这些算力需求的提升直接推动了高性能计算和云计算等相关技术的发展。

根据云岫资本,大模型发展的重点在算力提升,数据量的持续攀升对算力提出了更高的要求,如何进行大规模数据的高效处理和存储是当前算力设施面临的两大挑战。算力需求的提升也带来了计算资源的紧张,随着AI技术的广泛应用,越来越多的企业和机构需要部署AI大模型,导致计算资源的需求急剧增加。这种资源的紧张状况,促使计算产业不断寻求新的解决方案,如采用更高效的计算架构、优化算法等,以提高计算效率和资源利用率。

图:AI大模型高速发展 算力需求不断提高

AI场景CPU价值量占比提升,ARM处理器加速渗透

算力需求持续增加,CPU作为计算机系统的核心,其在大模型推理、多任务处理等方面的价值逐渐凸显。在AI市场中,企业越来越注重“效价比”,即综合考量大模型训练和推理过程中所需软硬件的经济投入成本、使用效果和产品性能。CPU因其灵活性和通用性,在多个AI应用场景中展现出较高的性价比。由于CPU价值量的提升,各大厂也都纷纷布局自研AI芯片+ARM服务器CPU。例如,2023年亚马逊发布新的Trainium2人工智能芯片和通用的Gravition4 ARM处理器,英伟达发布GH200 Grace Hopper 采用ARM架构的Grace CPU 和GH 100 Hopper计算GPU。Microsoft也推出云端AI芯片微软Azure Maia 100+ARM服务CPU微软Azure Cobalt 100,国内的科技巨头如华为也打造了ARM架构的鲲鹏+达芬奇架构的昇腾AI服务器。根据TrendForce等权威机构的预测,随着云数据中心对ARM架构服务器的采用逐渐增加,预计到2025年,ARM架构在数据中心服务器市场的渗透率将达到22%。这一数据表明,ARM处理器正在加速渗透数据中心市场。

图:2025年全球数据中心ARM服务器占比将超过22%

RISC-V与AI加速融合,2030年在主流应用中占比或达30%。

RISC-V与AI的加速融合是当前科技领域的一个显著趋势,这一趋势有望在未来几年内显著改变计算架构和芯片设计领域。根据云岫资本,2023年RISC-V基金会会员达到40037家,同比增长26%。根据Omdia的研究,RISC-V处理器出货量在未来几年将显著增长。预计从2024年至2030年,基于RISC-V的处理器出货量每年将增长近50%,到2030年处理器出货量将达到170亿颗。这一增长趋势反映了RISC-V架构在市场上的强劲势头和广泛应用前景。

尽管工业领域仍将是RISC-V技术的最大应用领域,但预计在汽车领域将实现最强劲的增长。同时,AI的崛起也有助于RISC-V的持续上升。RISC-V与AI的加速融合以及其在主流应用中的占比提升是一个明显的趋势,预计到2030年,RISC-V在多个领域的应用占比将达到30%,显示出其在AI时代的重要地位和潜力。

相关阅读: