近年来,人工智能快速发展。人工智能的崛起是21世纪最显著的技术趋势之一,它正在以前所未有的速度和规模重塑世界。而AI芯片的关键之一高带宽内存(HBM)成为行业的焦点。

与传统DRAM相比,HBM有着许多显著的优点。例如:HBM通过使用TSV(硅通孔)技术将多个DRAM芯片垂直堆叠在一起,这种设计允许更多的内存芯片紧密连接到处理器或GPU,从而实现更高的内存容量和带宽。HBM提供比传统DDR内存更高的内存带宽,这对于需要处理大规模数据集和复杂计算任务的高性能计算、深度学习和图形渲染等应用至关重要。另外,由于HBM的堆叠设计和更短的数据传输路径,其功耗相对较低。HBM内存芯片与CPU或GPU封装在同一模块中,有助于减小芯片的物理尺寸,使得高性能计算设备更加紧凑和便携。对于高性能计算和AI服务器,因其高带宽和高容量特性,能够满足这些应用对数据处理速度的极高要求。

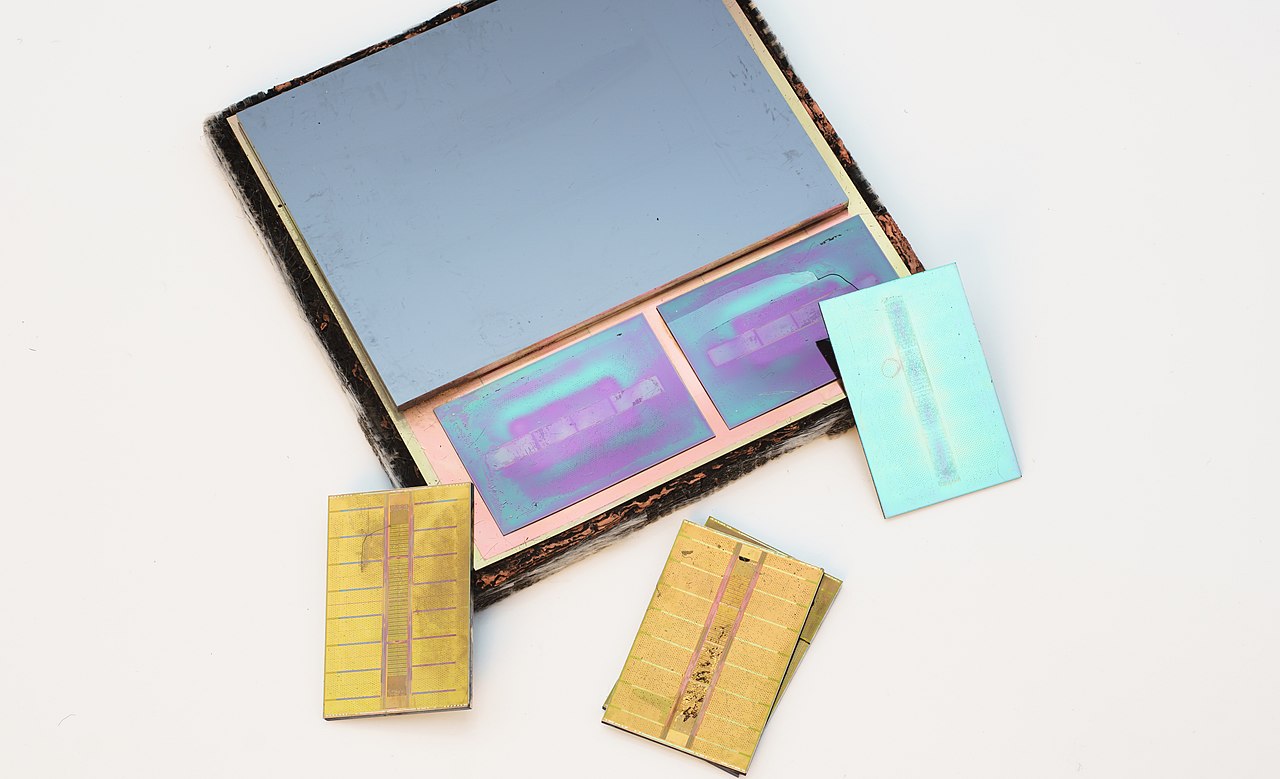

图:HBM成科技巨头新宠

自2016年第一代HBM1发布以来,HBM技术已经经历了多次迭代,每一代产品都在带宽、I/O速率、容量等方面取得了显著提升。生成式AI的出现让高带宽炙手可热,根绝市场调查数据显示,2024全年HBM供应给位元年增预估高达260%。据Gartner的预测报告,2023年全球HBM营收规模约为20.05亿美元;预计到2025年,HBM的市场规模将翻倍成长至49.76亿美元,增长率高达148.2%。

目前市面上的HBM供应商仅有SK海力士、三星、美光,随着AI市场的火热发展,HBM的产能显得有些不足,科技巨头排队购买。尽管这三大长正加大对HBM的资本支出和产能,但短期内仍难以满足市场对HBM的旺盛需求。根据Semiconductor-Digest预测,到2031年,全球高宽带存储器市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。

美光公司在2023年曾表示,HBM next(即HBM4)内存将于2026年左右面世,每堆栈容量介于36GB-64GB,每堆栈峰值带宽为2TB/s或更高。据悉,三星电子也在扩大其HBM生产力,建立新的封装线,用于大规模生产HBM,目标将HBM产能提高一倍。SK海力士的第五代HBM3E产品也预计在今年上半年开始量产。