在人工智能技术快速演进的当下,数据传输速率与互联效率日益成为限制AI系统性能提升的关键瓶颈。尤其在大模型计算与数据中心扩展中,高带宽、低延迟的加速器互联方案已成为AI硬件生态中的战略高地。近日,UALink Consortium主导的首款支持UALink规范的高速互联芯片即将进入流片阶段,引发行业广泛关注。与此同时,英伟达(NVIDIA)则通过其新一代NVLink Fusion持续巩固在AI互联领域的领先地位。开放式生态与封闭平台的对抗,正在重塑AI芯片互联的产业版图。

一、UALink:开放互联生态的新起点

根据《电子时报》2024年6月报道,由AMD、博通、谷歌、HPE、英特尔和微软等多家企业共同成立的UALink Consortium,计划于2025年底流片首款符合UALink规范的高速互联芯片。这标志着该技术正由标准设定阶段迈向实际产品化,预示着2026年将可能看到首批基于UALink的服务器与AI系统落地。

UALink(Ultra Accelerator Link)是面向AI和高性能计算场景而设计的开放标准,目标是在加速器、CPU和交换芯片之间提供高带宽、低延迟的通信能力。与传统PCIe、CCIX或NVLink等方案相比,UALink更强调开放性和可扩展性,可实现厂商间更广泛的协作。例如,UALink 1.0版本提供每通道最高50GB/s双向传输速率,并支持多达1024个加速器的互联配置,在设计上面向超大规模模型的训练需求。

这种高度可组合的互联结构,将为数据中心提供更灵活的拓扑部署方案,降低厂商对单一供应商技术的依赖,也为中小厂商进入AI算力基础设施市场提供了窗口。

二、对比NVLink Fusion:开放对抗封闭,生态格局暗涌

1. 开放性与生态战略

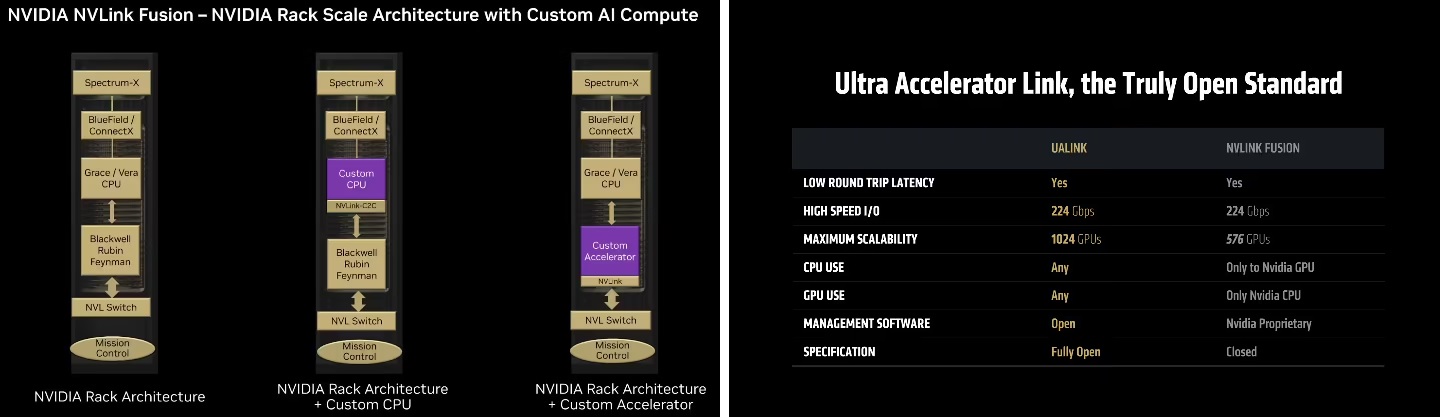

在生态策略上,UALink主打“完全开放”的标准联盟模式。无论是处理器供应商、云服务提供商,还是独立硬件开发商,均可基于UALink设计加速器或互联设备。这种策略显著区别于NVIDIA的NVLink Fusion,其虽在2024年发布时声称对合作伙伴“部分开放”,但仍要求至少一端采用NVIDIA设计的CPU或加速器IP,实际仍以封闭生态为主。

这一点在平台适配上尤为明显。UALink允许CPU和GPU厂商自由组合,利于形成多元技术共存的市场格局,而NVLink Fusion更像是NVIDIA硬件栈(如Grace CPU与Hopper GPU)向纵深一体化的延伸,绑定效应更强。

2. 性能与可扩展性

在原始性能指标方面,NVIDIA NVLink保持领先优势。其第五代技术(用于H100与GH200平台)单个GPU可实现高达1.8TB/s的双向互联带宽,远超PCIe 5.0(约64GB/s)与传统CCIX接口,是AI训练与推理任务高带宽要求的重要支撑。

但从拓扑扩展角度看,UALink提供了更高的系统级连接能力。其结构支持更大规模的设备互联,理论上可支撑数百甚至上千个加速器节点协同计算。在面向下一代多模态大模型的计算架构设计中,这种大规模集群支持能力可能成为关键竞争点。

3. 生态成熟度与市场依赖

NVIDIA多年来在AI领域深耕,其CUDA软件生态与硬件平台高度耦合,使NVLink技术在DGX系统、超级计算机及多个云厂商实例中被广泛部署。这一封闭且成熟的系统生态,极大增强了NVIDIA在AI硬件供应链中的控制力。

相比之下,UALink尚处于早期发展阶段,虽有多家巨头参与,但仍需经过芯片流片、主板验证、驱动适配、编译器优化等多个环节的市场验证,生态建设的完整度尚不及NVLink。但从长远看,其“平台中立+多厂商协同”的战略路径更利于降低行业进入壁垒,打破单一厂商垄断。

图:NVLink Fusion要求必须有英伟达CPU或ASIC,UALink生态开放且设备量有优势

三、市场展望:多元互联架构成为趋势

从整个AI基础设施发展的路径来看,单一互联技术难以满足所有场景的需求。数据中心的AI训练集群、边缘侧推理设备、云端加速器服务等应用场景各自对带宽、拓扑和延迟有不同要求,这决定了未来将是多个技术方案并行发展的局面。

UALink若能在2025年顺利流片,并完成服务器端部署验证,有望在2026年开始参与新一轮AI集群建设项目的竞标。尤其在部分非NVIDIA阵营企业(如AMD、Intel、Google Cloud)推动下,UALink可能成为构建异构算力平台的重要底层互联标准。

与此同时,NVIDIA也不会坐以待毙。NVLink Fusion的推出,结合其在软件生态和AI模型部署上的优势,依然将在高端AI服务器市场保持强势。预计未来几年,UALink与NVLink Fusion将在不同细分场景展开差异化竞争:前者主打开放与横向扩展能力,后者则凭借垂直整合与生态闭环主导特定高端市场。

四、挑战与关键变量

尽管UALink具备潜在优势,但仍面临数项现实挑战:

* 生态构建周期长:软件栈、驱动支持、主板设计和测试验证等仍需时间完善。

* 市场接受度不确定:大型云厂商在已有架构上是否愿意迁移至UALink仍是问号。

* 技术标准演进需谨慎:后续1.1/2.0规范的推出需保持兼容性与性能可持续提升。

这些都需要UALink联盟在技术推广、合作机制和行业标准制定上进一步加强协调。

五、结语:生态变局开启,谁能成为AI互联基础设施的新霸主?

首款UALink规范芯片即将流片,标志着AI互联技术迈入多极竞争的新阶段。这不仅是技术性能的对决,更是开放式与封闭式生态路径的博弈。在AI算力成为国家战略、企业核心资源的背景下,互联芯片的格局重构,不仅关乎芯片厂商的竞争态势,更影响全球AI产业的基础设施布局。

未来几年,我们将见证一个重要趋势的形成:AI互联标准从“单一主导”向“多元竞合”演进。无论是选择NVIDIA的封闭栈,还是投向UALink的开放联盟,企业需基于自身业务需求、开发资源与未来兼容性权衡利弊,制定出最适配的战略路线图。